AMD 正式出击,推出最新AI芯片挑战英伟达

尽管近段时间,英伟达在 AI 领域崭露头角,但 AMD 今日的发布,势必要在算力芯片领域掀起一场「腥风血雨」。

本文引用地址://www.cghlg.com/article/202306/447698.htm今天,AMD 数据中心和人工智能首映式上,推出了针对云和技术应用程序的 Epyc 处理器,以及其 Instinct MI300 系列加速器的详细计划。

首先是新一代的 Epyc 处理器,Bergamo 是针对云原生应用的产品线,也是第一款使用 Zen 4c 架构的产品。

其次,AMD 还在活动中展示了其最新的缓存堆叠 X 芯片,代号为 Genoa-X。Genoa-X 与具有相同内核数的 Intel Xeon 的比较,性能提高了 2.2 倍和 2.9 倍。

最后,AMD 宣布新款 GPU 专用的 MI300X AI 加速器,并表示 MI300X 和 8-GPU Instinct 平台将在第三季度出样,并在第四季度推出。

在会议开始时,AMD 全球总裁兼 CEO 苏姿丰表示:「今天,我们在数据中心战略上又向前迈出了重要一步,因为我们扩展了第四代 EPYC 处理器系列,为云和技术计算工作负载提供了新的领先解决方案,并宣布了与最大的云提供商的新公共实例和内部部署。」

「人工智能是塑造下一代计算的决定性技术,也是 AMD 最大的战略增长机会。我们专注于加速 AMD AI 平台在数据中心的大规模部署,计划于今年晚些时候推出我们的 Instinct MI300 加速器,以及为我们的硬件优化的企业级 AI 软件生态系统不断壮大。」

AMD 再次让人发出欢呼:「AMD YES!」

Bergamo

AMD 宣布为数据中心推出代号为 Bergamo 的第四代 EPYC(霄龙) 处理器。

Bergamo 是针对云原生应用的产品线,也是第一款使用 Zen 4c 架构的产品。Bergamo 在架构进行精简,但着重保有与 Zen 4 一脉相承的 x86 架构,并重新设计 L3 快取系统,相较完整的 Zen 4 架构缩减 35% 的裸片面积。

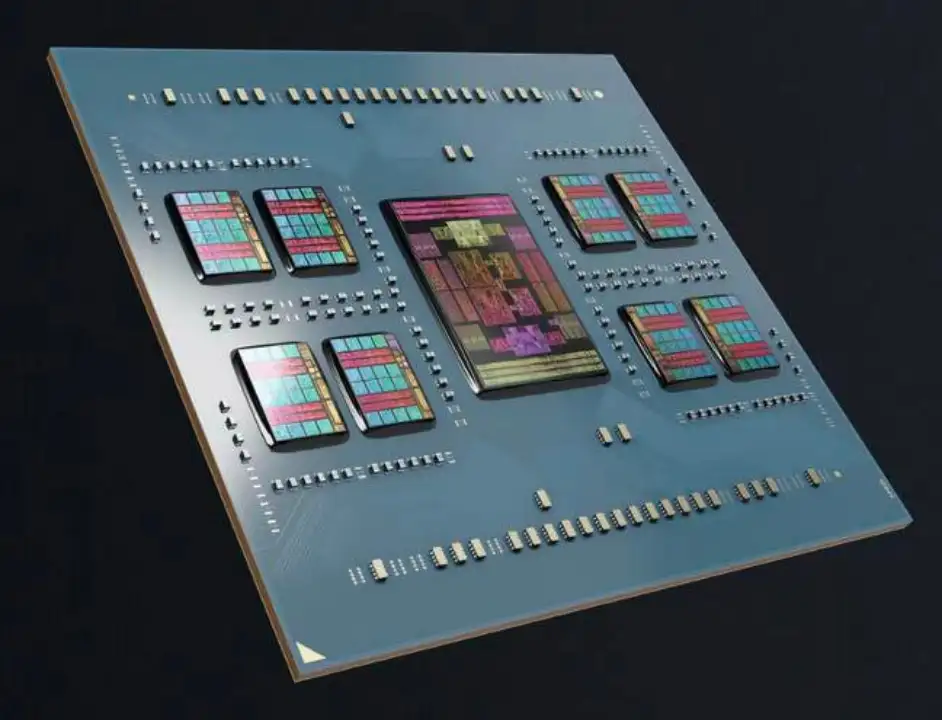

AMD 的 Bergamo Epyc 处理器具有 128 个核心和 256 个线程,分布在八个核心复合芯片上

同时单一 CCD 具备 16 个 Zen 4c,一颗 Bergamo 最多由 8 个 CCD 构成,具备最高 128 核心的特质,采用台积电 5nm 制程共有高达 820 亿个晶体管。

Bergamo 芯片目前正在向大型云计算客户「批量出货」。Meta 就是其客户之一,Meta 代表与 Lisa Su 一起上台讨论了 Meta 在其基础架构中使用 AMD EPYC 处理器的情况。

Meta 计划为其基础架构使用 Bergamo,它的性能比上一代 Milan 芯片高出 2.5 倍。Meta 还将使用 Bergamo 作为其存储平台。

Genoa-X

AMD 在会议上展示了最新的缓存堆叠 X 芯片,代号为 Genoa-X。Genoa-X 主要针对高性能计算应用程序,包括计算流体动力学、电子设计自动化、有限元分析、地震层析成像和其他带宽敏感型工作负载。

AMD 于去年 6 月首次透露,Genoa-X 是 AMD 现在强制配备 V-cache 的 EPYC 服务器 CPU。

AMD 的 Genoa-X CPU 在每个芯片计算芯片上堆叠了 64MB SRAM 块,总共有 1.1GB 的三级缓存

AMD 正在使用缓存芯片堆叠为其他常规的 Genoa Zen 4 CCD 添加更多的 L3 缓存,从而为 AMD 提供了一种生产高缓存芯片设计的新颖方法,而无需实际布置一个完整的独立芯片。在这种情况下,Genoa/Genoa-X 芯片上有 12 个 CCD,这允许 AMD 向芯片添加 768MB 的额外 L3 缓存。

这种高缓存 SKU 针对的是工作负载的利基细分市场,如上文提到的计算流体动力学、电子设计自动化等,这些工作负载特别受益于额外的缓存。AMD 表示 Genoa-X 可提供多达 96 个内核和总计「1.1GB」的三级缓存。

Genoa-X 与具有相同内核数的 Intel Xeon 的比较,缓存提升意味着在各种计算流体动力学和有限元分析工作负载负载方面的性能提高了 2.2 倍和 2.9 倍。

MI300 正面决战英伟达 H100

接下来,Lisa Su 开始了今天的重头戏——Instinct MI300。ADM 表示,AMD Instinct GPU 已经为许多世界上最快的超级计算机提供动力。

AMD Instinct MI300 于去年 6 月首次发布,并在 2023 年国际消费电子展上进行了更深入的详细介绍,这是 AMD 在 AI 和 HPC 市场的重要一步。

AMD 展示「AMD Instinct MI300 系列加速器」(以下简称 Instinct MI300 系列)。有纯 GPU「AMD Instinct MI300X 加速器」(以下简称 Instinct MI300X)和 APU(CPU+GPU)「AMD Instinct MI300A」(以下简称 Instinct MI300A)两款产品。

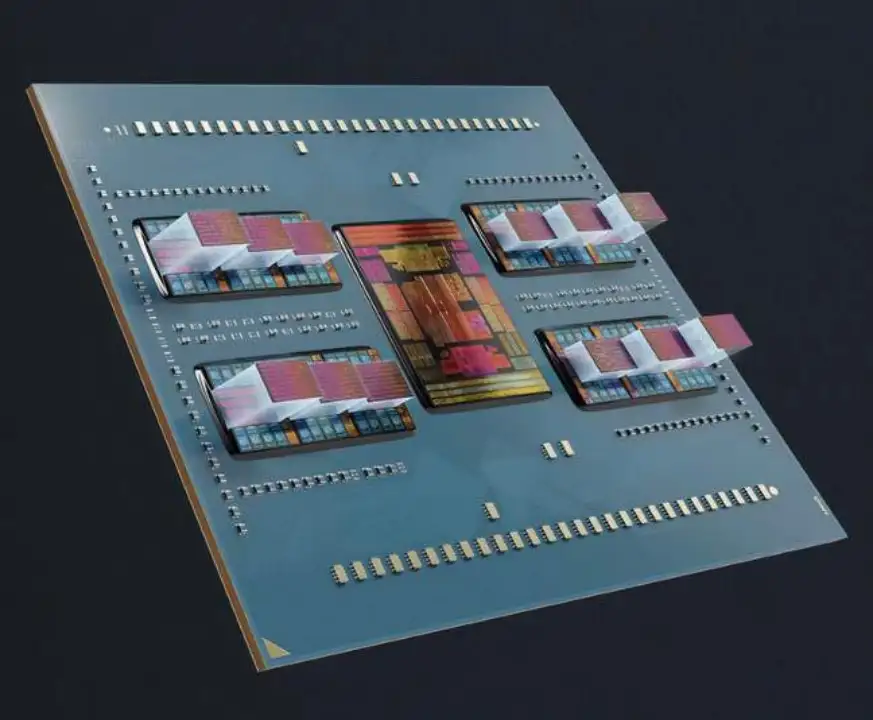

首先看来 Instinct MI300X,全新的 MI300X 服务器 GPU,它是 MI300A APU 的变体。Instinct MI300X 是继传统 Instinct MI200 系列加速器之后的一款面向数据中心的 GPU,采用 CDNA 3,即传统 MI200 系列使用的 GPU 架构 CDNA 2 的后继产品。

其将三个 Zen 4 芯片替换为三个 CDNA 3 芯片,并增加了 64GB 的 HBM3,总容量为 192GB。与 MI250 相比,提高了 8 倍的性能和 5 倍的效率。

Instinct MI300X 由 12 个不同的小芯片组成,其中包括八个 GPU 和几个 I/O 芯片,总共有令人惊讶的 1530 亿个晶体管。

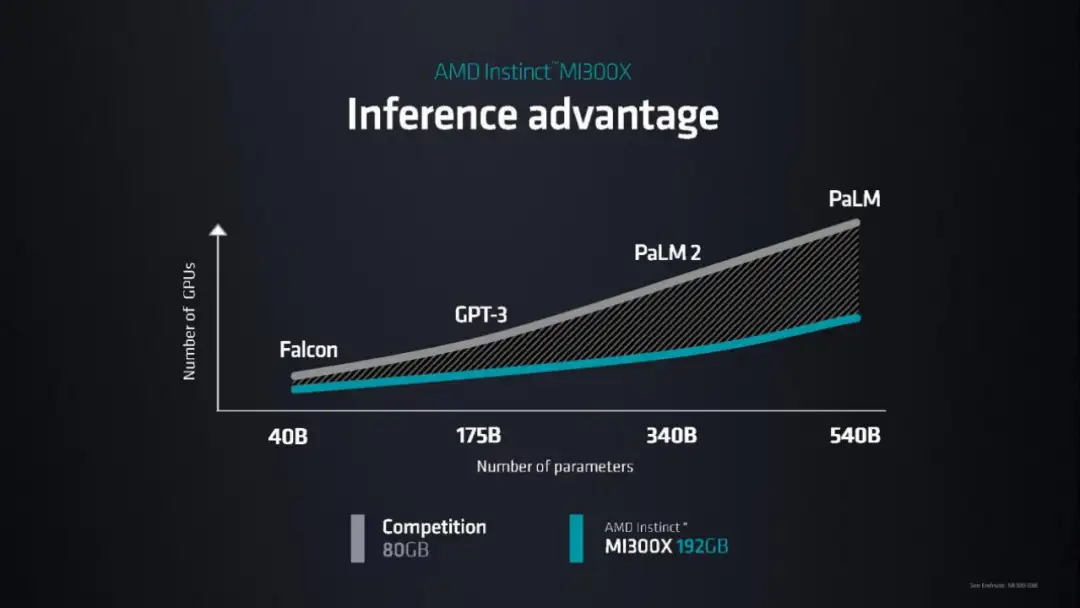

这款 Instinct MI300X 的一个模块具有处理 LLM 的「Falcon-40B」400 亿参数的能力。提供了 192GB 的 HBM3、5.2TB/s 的带宽和 896GB/s 的 Infinity Fabric 带宽。

MI300X 提供的 HBM 密度是 Nvidia H100 的 2.4 倍,HBM 带宽是 H100 的 1.6 倍,这意味着 AMD 可以运行比 Nvidia 芯片更大的模型。

Lisa Su 当场对运行 Hugging Face AI 模型的 MI300X 进行了演示,让写了一首关于旧金山的诗。这是第一次在单个 GPU 上运行这么大的模型,单个 MI300X 可以运行一个高达 800 亿个参数的模型。

再来看 Instinct MI300A,Instinct MI300A 是一款数据中心 APU,它混合了总共 13 个小芯片,其中许多小芯片是 3D 堆叠的。具有 24 个 Zen 4 CPU 内核、融合了 CDNA 3 图形引擎和 8 个 HBM3 内存堆栈的单芯片封装总计 128GB。

九个计算裸片混合了 5nm CPU 和 GPU,它们以 3D 方式堆叠在四个 6nm 基础裸片之上,这些裸片是处理内存和 I/O 流量以及其他功能的有源中介层。

总体来看,Instinct MI300A 拥有 1460 亿个晶体管,是 AMD 投入生产的最大芯片。

此外,Lisa Su 还发布了 AMD Instinct 平台,该平台拥有 8 个采用行业标准 OCP 设计的 MI300X,提供总计 1.5TB 的 HBM3 内存。

MI300A,CPU+GPU 机型,现已出样。MI300X 和 8-GPU Instinct 平台将在第三季度出样,并在第四季度推出。最先进的人工智能 GPU MI300X 将于今年晚些时候开始向部分客户发货。

AMD Pensando DPU

除此之外,AMD 已经公布了「AMD Pensando DPU」。Pensando DPU 是 AMD 在去年(2022 年)5 月宣布完成收购的 Pensando Systems 衍生出来的产品,可以摆脱这种处理,提高整个数据中心的 CPU 处理能力。可以说,该产品与 NVIDIA 称为 DPU、Intel 称为 IPU 的产品具有相同的功能。

此次除了在数据中心和 AI 技术首映会上展示之外,还公开了下一代 DPU 产品「Giglio」(开发代号,Giglio)的存在。据 AMD 称,与目前的同类产品相比,它将提供更高的性能和能效,并将于 2023 年底上市。

此外,AMD 宣布将开始向客户提供 Pensando Software-in-Silicon Developer Kit (Pensando SSDK) 作为 AMD Pensando DPU 的软件开发套件。因此,AMD 解释说,将有可能将使用 Pensando DPU 的网络虚拟化和安全功能等功能整合到软件中。

评论